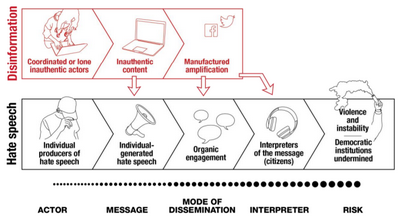

Контекст снижает расовые предубеждения в алгоритмах обнаружения языка ненависти

Так что, возможно, неудивительно, что алгоритмы обнаружения языка вражды в социальных сетях, разработанные для того, чтобы остановить распространение языка ненависти, на самом деле могут усилить расовую предвзятость, блокируя безобидные твиты чернокожих или других членов групп меньшинств.

Фактически, одно предыдущее исследование показало, что модели искусственного интеллекта.В 5 раз выше вероятность того, что твиты, написанные афроамериканцами, будут отмечены как «оскорбительные» – другими словами, ложноположительные – по сравнению с другими твитами.

Почему? Потому что текущие модели автоматического обнаружения упускают кое-что жизненно важное: контекст.

В частности, классификаторы языка вражды чрезмерно чувствительны к таким групповым идентификаторам, как «черный», «гей» или «трансгендер», которые при использовании в некоторых условиях являются только индикаторами языка вражды.

Теперь команда исследователей USC создала классификатор языка вражды, который более зависим от контекста и с меньшей вероятностью ошибочно примет сообщение, содержащее идентификатор группы, за язык вражды.

Для этого исследователи запрограммировали алгоритм, учитывающий два дополнительных фактора: контекст, в котором используется групповой идентификатор, и наличие специфических черт языка ненависти, таких как унижающие человеческое достоинство и оскорбительные выражения.

«Мы хотим приблизить обнаружение языка ненависти к тому, чтобы оно было готово к применению в реальном мире», – сказал Брендан Кеннеди, аспирант по информатике и соавтор исследования, опубликованного на ACL 2020, 6 июля.

«Модели обнаружения языка ненависти часто« ломаются »или дают неверные прогнозы при представлении реальных данных, таких как социальные сети или другие текстовые данные в Интернете, потому что они смещены данными, на которых их учат ассоциировать появление социальные термины, идентифицирующие язык вражды.»

Дополнительными авторами исследования под названием «Контекстуализация классификаторов языка ненависти с пост-Hoc объяснением» являются соавтор Сисен Цзи, аспирант USC по информатике, и соавторы Аида Мостафазаде Давани, аспирант по информатике, Сян Рен , доцент кафедры информатики и Мортеза Дехгани, занимающаяся совместными приемами в области психологии и информатики

Почему случается предвзятость ИИ

Обнаружение языка ненависти является частью постоянных усилий по борьбе с репрессивными и оскорбительными высказываниями в социальных сетях с использованием сложных алгоритмов для выявления расистских или агрессивных высказываний быстрее и лучше, чем в одиночку. Но модели машинного обучения склонны к изучению человеческих предубеждений на основе данных обучения, которые используются в этих алгоритмах.

Например, алгоритмам сложно определить, используются ли идентификаторы группы, такие как «гей» или «черный», оскорбительным или предвзятым образом, потому что они обучаются на несбалансированных наборах данных с необычно высокими показателями ненавистнических высказываний (например, форумы сторонников превосходства белых). В результате модели трудно обобщить на реальные приложения.

«Ключевым моментом для моделей является не игнорировать идентификаторы, а сопоставлять их с правильным контекстом», – сказал профессор Сян Рен, эксперт по обработке естественного языка.

«Если вы обучаете модель на основе несбалансированного набора данных, модель начинает улавливать странные закономерности и неправомерно блокировать пользователей.»

Чтобы протестировать системы, исследователи получили доступ к большой случайной выборке текста из социальной сети Gab, с высоким уровнем ненавистнических высказываний, и из Stormfront, веб-сайта сторонников превосходства белой расы. Текст был вручную отмечен людьми как предвзятый или бесчеловечный.

Затем они измерили тенденции современной модели по сравнению с тенденциями своей собственной модели к ненадлежащему обозначению ненанавистнических высказываний, используя 12 500 статей в New York Times, лишенных языка вражды, за исключением цитаты. Современные модели достигли 77% точности определения ненависти и отсутствия ненависти. Модель USC смогла повысить этот показатель до 90%.

«Эта работа сама по себе не делает обнаружение языка вражды идеальным, это огромный проект, над которым многие работают, но он постепенно продвигается», – сказал Кеннеди.

«Помимо предотвращения ненадлежащей цензуры постов членов защищенных групп в социальных сетях, мы надеемся, что наша работа поможет гарантировать, что обнаружение языка вражды не причиняет ненужного вреда, укрепляя ложные ассоциации предрассудков и дегуманизации с социальными группами.»